Науковці створили новий тип машинного навчання. Фішка в тому, що він періодично “забуває” нові знання. Дослідники впевнені, що така особливість дозволить більш швидко вивчати різні мови, інформує видання "Позиція".

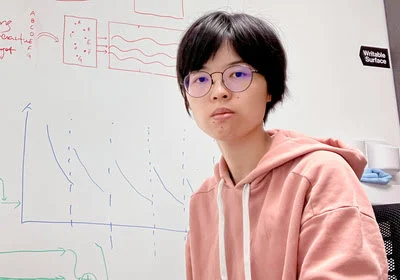

Відповідне дослідження опубліковане в журналі Nature Communications. Джеа Квон, інженер зі штучного інтелекту, називає новий метод значним досягненням у комп'ютернійгалузі.

Модель використовує штучні нейронні мережі. Це шари математичних функцій, що обробляють інформацію. Штучний інтелект навчається на великих обсягах текстових даних, використовуючи лінгвістичні закономірності та правила окремих мов.

Але процес самонавчання потребує багато обчислень. Технологію важко змінювати. Мікель Артетксе, співавтор дослідження, пояснює проблему.

“Уявіть, що у вас є модель зі 100 мовами. Але є одна мова, яка вам потрібна, але вона невідома машині. Ви починаєте все з нуля. Як на мене, це не ідеально”.

Артетксе та його колеги запропонували новий метод навчання. Вони періодично стирали інформацію в першому шарі мережі. Там зберігались основні одиниці слів, токени. Потім інженери перенавчали модель з новими токенами з різних мов. Решта мережі залишалася без змін.

Нарешті метод запрацював. Тепер модель може вивчати та обробляти нові мови. Навіть якщо така мова містила невідповідну інформацію.

Дослідники так пояснюють технологію: глибинні шари мережі генерують абстрактну інформацію. Вона стосується лінгвістичних практик, що лежать в основі людських мов. Що допомагає моделі узагальнювати нові знання.

“Ми живемо в одному світі. Ми концептуалізуємо одні й ті ж речі різними словами”, - каже Іхон Чен, провідний автор статті.

“Ми живемо в одному світі. Ми концептуалізуємо одні й ті ж речі різними словами”, - каже Іхон Чен, провідний автор статті.

“Ось чому модель пропонує однакові пропозиції високого рівня. Яблуко - це щось солодке і соковите, а не просто слово”.

Дослідники протестували свій метод на популярній мовній моделі “Роберта”. Вони порівняли його зі звичайним методом навчання. Виявилось, що їхній метод працює трохи гірше однією мовою. Але набагато краще, коли модель “вчиться” на інших мовах.

Тому машинне навчання потребує набагато менших наборів даних та обчислювальних обмежень. Тривалість навчання можна скоротити.

Науковці також дійшли висновку, що періодичне забування в цілому самовдосконалює мережу, перетворюючи навчання мовам у легку прогулянку.

“Оскільки модель продовжує забувати, навчити мережу чомусь новому стає легше”, - впевнений Євген Нікішин, який представляє дослідницький центр машинного навчання у Квебеку.

Він додає: мережа розуміє мову на більш глибокому рівні, ніж просто значення окремих слів.

Щобільше, метод працює як людська пам’ять.

“Людська пам’ять загалом не дуже добре зберігає великі обсяги детальної інформації. Ми схильні запам’ятовувати суть нашого досвіду, абстрагуючись і екстраполюючи”, - розповідає нейробіолог Бенджамін Леві.

За його словами, адаптивне забування - один зі способів зробити штучний інтелект більш гнучким у роботі.

С свою чергу, Іхон Чен уявляє світ, де панують “гнучкі” моделі ШІ:

“Я думаю про ситуацію, коли світу не потрібна одна велика мовна модель. Але все це — поки що плани”.